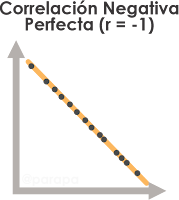

El coeficiente de correlación de Pearson, llamado también coeficiente de correlación lineal o \(r\) de Pearson, es una medida estadística paramétrica, que cuantifica significativamente la relación lineal entre dos variables cuantitativas. Este coeficiente fue desarrollado por Karl Pearson en 1895, para medir la fuerza y la dirección de la relación lineal entre variables cuantitativas, sus valores se encuentran entre -1 y +1, en el que -1 indica una correlación negativa perfecta, +1 una correlación positiva perfecta y 0 ausencia de correlación lineal y que, en su forma gráfica, mide como se agrupan los puntos de datos alrededor de una línea recta que representaría una correlación perfecta.

Entonces, la correlación lineal es un método que permite medir la intensidad de la relación lineal entre dos variables; cuando existe una correlación lineal positiva, ambas variables aumentan juntas, por el contrario, si es negativa, una variable disminuye a medida que la otra aumenta. Existen coeficientes de correlación paramétricos, como la Correlación de Pearson (cuya distribución de datos debe cumplir ciertos supuestos para ser aplicados) y no paramétricos (aquellos conjuntos de datos que no necesitan cumplir supuestos), es importante seleccionar el coeficiente adecuado para obtener resultados válidos y evitar conclusiones equivocadas..

Definición Matemática

Calculamos \(r\) de Pearson a partir de covarianzas y varianzas:

\[r_{XY} = \frac{\sigma_{XY}}{\sigma_X \sigma_Y} =\frac{Cov(X,Y)}{\sqrt{Var(X) * Var(Y)}}\]

\[Cov(X,Y) = \frac{\sum_{i=1}^{n} (x_i - \bar{x})(y_i - \bar{y})}{n}\]

\[Var(X) = \frac{\sum_{i=1}^{n} (x_i - \bar{x})^2}{n}\]

\[Var(X) = \frac{\sum_{i=1}^{n} (y_i - \bar{y})^2}{n}\]

Finalmente:

\[r_{XY} = \frac{\sum_{i=1}^{n} (x_i - \bar{x})(y_i - \bar{y})}{\sqrt{\sum_{i=1}^{n} (x_i - \bar{x})^2 \sum_{i=1}^{n} (y_i - \bar{y})^2}}\]

Donde:

- \(x_i\) y \(y_i\) son los valores individuales de las variables de \(X\) y \(Y\), respectivamente.

- \(\bar{x}\) y \(\bar{y}\) son las medias de las variables \(X\) y \(Y\), respectivamente.

- \(n\) es el número de observaciones.

Supuestos

El coeficiente de correlación de Pearson es una medida paramétrica y para que la mayoría de las pruebas paramétricas sean válidas, deben cumplirse ciertos supuestos como:

a) Linealidad: La relación entre las variables debe ser lineal.

Hipótesis:

H₀: La relación entre las dos variables es lineal.

H₁: La relación entre las dos variables no es lineal.

Evaluación del supuesto:

Las pruebas más comunes para evaluar la linealidad son: pruebas de bondad de ajuste y la visualización mediante un gráfico de dispersión (scatter plot)

Interpretación:

Si p-valor > α, no se rechaza H₀ y se asume que la relación es lineal.

Si p-valor ≤ α, se rechaza H₀ y se concluye que la relación no es lineal.

b) Normalidad: Las dos variables deben ser continuas y aproximadamente normales.

Hipótesis:

H₀: Las dos variables están distribuidas normalmente.

H₁: Al menos una de las variables no está distribuida normalmente.

Evaluación del supuesto:

Las pruebas más usadas para comprobar la normalidad de las variables son: prueba de Shapiro-Wilk y prueba de Kolmogorov-Smirnov, además de la visualización mediante gráficos Q-Q (quantile-quantile plot).

Interpretación:

Si p-valor > α, no se rechaza H₀ y se asume que las variables son normales.

Si p-valor ≤ α, se rechaza H₀ y se concluye que las variables no son normales.

c) Independencia de las Observaciones: Las observaciones deben ser independientes.

Hipótesis:

H₀: Las observaciones son independientes entre sí.

H₁: Las observaciones no son independientes entre sí.

Evaluación del supuesto:

Generalmente se usa la prueba Durbin-Watson.

Interpretación:

Si p-valor > α, no se rechaza H₀. Se asume que las observaciones son independientes.

Si p-valor ≤ α, se rechaza H₀. Se concluye que las observaciones no son independientes.

d) Homocedasticidad (varianza constante): la variabilidad de los datos debe ser constante a lo largo del rango de valores, entonces, los errores no varían mucho cuando cambia el valor de las variables independientes.

Hipótesis:

H₀: La varianza de los errores es constante en todos los valores de las variables independientes.

H₁: La varianza de los errores no es constante en todos los valores de las variables independientes.

Evaluación del supuesto:

La comprobación de la homocedasticidad puede realizarse mediante pruebas como Breusch-Pagan y visualización con un gráfico de dispersión de residuos frente a los valores ajustados.

Interpretación:

Si p-valor > α, no se rechaza H₀ y se asume que existe homocedasticidad.

Si p-valor ≤ α, se rechaza H₀ y se concluye que existe heterocedasticidad.

Dirección y fuerza

La correlación cuantifica el grado en que dos variables se mueven juntas y predice cómo el cambio en una variable afectará a la otra, entonces, mide la fuerza y la dirección de la relación lineal entre dos variables cuantitativas, de la siguiente forma:

* \(r = 1\): Correlación positiva y perfecta; significa que los puntos de datos caen exactamente en una línea recta ascendente.

* \(0 < r < 1\): Correlación positiva, cuando los puntos de datos tienden a ascender en conjunto, pero no forman una línea recta perfecta; a medida que r se acerca a 1, la relación lineal positiva se vuelve más fuerte.

* \(r = 0\): No existe correlación lineal aparente entre las dos variables, sin embargo, puede existir una relación no lineal.

* \(-1 < r < 0\): Correlación negativa donde los puntos de datos tienden a descender en conjunto, pero no forman una línea recta perfecta; a medida que \(r\) se acerca a -1, la relación lineal negativa se vuelve más fuerte.

* \(r = -1\): Correlación perfecta y negativa, cuando los puntos de datos caen exactamente en una línea recta descendente.

Interpretación

Como se ha visto, el coeficiente de correlación de Pearson puede tomar valores entre -1 y +1, donde 0 indica que no hay correlación entre las variables, valores menores a 0 indican relación negativa y valores mayores a 0, indican relación positiva. Para interpretar la fuerza de las correlaciones, los valores del coeficiente deben ser analizados más profundamente, para lo cual, muchos autores han clasificado ciertos rangos de valores para mejorar la interpretación, en el siguiente cuadro tenemos una de ellas:

| Valor de \(r\) de Pearson | Significado |

|---|---|

| -1 | Correlación negativa perfecta |

| [-0.90 a -0.99] | Correlación negativa muy alta |

| [-0.70 a -0.89] | Correlación negativa alta |

| [-0.40 a -0.69] | Correlación negativa moderada |

| [-0.20 a -0.39] | Correlación negativa baja |

| [-0.01 a -0.19] | Correlación negativa muy baja |

| 0 | Correlación nula |

| [0.01 a 0.19] | Correlación positiva muy baja |

| [0.20 a 0.39] | Correlación positiva baja |

| [0.40 a 0.69] | Correlación positiva moderada |

| [0.70 a 0.89] | Correlación positiva alta |

| [0.90 a 0.99] | Correlación positiva muy alta |

| 1 | Correlación positiva perfecta |

Significancia estadística

1. Cálculo de \(r\) de Pearson

2. Definición de la Prueba de Hipótesis

H₀: \(r = 0\) (No hay correlación lineal entre las dos variables)

H₁: \(r ≠ 0\) (Existe una correlación lineal entre las dos variables)

3. Nivel de significancia (comúnmente se establece 0.05)

α = 0.05 (con un nivel de confianza del 95%).

4. Prueba del supuesto de normalidad (para pruebas paramétricas)

a) Hipótesis

H₀: Las dos variables están distribuidas normalmente.

H₁: Al menos una de las variables no está distribuida normalmente.

b) Significancia:

α = 0.05 (puede variar por el tipo de estudio y el investigador)

c) Prueba de normalidad

Las pruebas más comunes son Shapiro-Wilk y Kolmogorov-Smirnov

d) Decisión

Al realizar la prueba de normalidad nos fijamos en el p-valor.

- Si p-valor > α, no se rechaza H₀, se asume que las variables son normales, entonces podemos continuar con el análisis de correlación con r de Pearson

- Si p-valor ≤ α, se rechaza H₀ y se concluye que las variables no son normales, entonces usamos otras pruebas no paramétricas como rho de Spearman, tau de Kendall, entre otros.

5. Estadístico de Prueba

Para el coeficiente de correlación de Pearson, utilizamos el estadístico de prueba \(t\), que sigue una distribución \(t\) de Student con \(n-2\) grados de libertad:

- \(r\) es el coeficiente de correlación de Pearson.

- \(n\) es el número de pares de datos.

6. Decisión

Si \(|t| > t_{\frac{\alpha}{2},n-2}\) (valor crítico), se rechaza \(H_0\) (entonces existe correlación lineal entre las variables).

Si \(|t| ≤ t_{\frac{\alpha}{2},n-2}\) (valor crítico), no se rechaza

\(H_0\) (no hay correlación lineal entre las variables).

Si \(p-valor ≤ \alpha\), se rechaza \(H_0\) (existe correlación lineal entre las variables).

Ejemplo

Como ejemplo, realizaremos el análisis manual de significancia estadística para la correlación entre dos variables X y Y.

Datos. Suponiendo que tenemos:

| X | Y |

| 1 | 2 |

| 2 | 3 |

| 3 | 1 |

| 4 | 6 |

| 5 | 8 |

| 6 | 7 |

| 7 | 5 |

| 8 | 9 |

1. Calculamos el Coeficiente de Correlación de Pearson (\(r\))

- Primero, hallamos las medias de X e Y (considerando n=8):

\(\bar{X} = \frac{1+2+3+4+5+6+7+8}{8} = 4.5\)

\(\bar{Y} = \frac{2+3+1+6+8+7+5+9}{8} = 5.125\)

- Luego, calculamos las desviaciones respecto a las medias:

| \(X_i\) | \(Y_i\) | \(X_i− \bar{X}\) | \(Y_i−\bar{Y}\) | \((X_i− \bar{X})(Y_i− \bar{Y})\) | \((X_i− \bar{X})^2\) | \((Y_i− \bar{Y})^2\) |

| 1 | 2 | -3.5 | -3.125 | 10.9375 | 12.25 | 9.766 |

| 2 | 3 | -2.5 | -2.125 | 5.3125 | 6.25 | 4.516 |

| 3 | 1 | -1.5 | -4.125 | 6.1875 | 2.25 | 17.016 |

| 4 | 6 | -0.5 | 0.875 | -0.4375 | 0.25 | 0.766 |

| 5 | 8 | 0.5 | 2.875 | 1.4375 | 0.25 | 8.266 |

| 6 | 7 | 1.5 | 1.875 | 2.8125 | 2.25 | 3.516 |

| 7 | 5 | 2.5 | -0.125 | -0.3125 | 6.25 | 0.016 |

| 8 | 9 | 3.5 | 3.875 | 13.5625 | 12.25 | 15.016 |

- Sumamos las columnas correspondientes:

\(\sum (X_i - \bar{X})(Y_i - \bar{Y}) = 39.5\)

\(\sum (X_i - \bar{X})^2 = 42.0\)

\(\sum (Y_i - \bar{Y})^2 = 58.875\)

- Finalmente, calculamos \(r\):

\( r = \frac{39.5}{\sqrt{42.0 \times 58.875}}\approx 0.795\)

Observamos que \(r=0.795\), lo que indica una correlación positiva y alta

2. Prueba de hipótesis

H₀: \(r = 0\) (No hay correlación)

H₁: \(r ≠ 0\) (Hay correlación)

3. Nivel de significancia:

\(\alpha = 0.05\) (con un nivel de confianza del 95%).

4. Prueba del supuesto de normalidad

Para continuar con el análisis de significancia de la correlación \(r\) de Pearson, determinamos la normalidad de los datos:

H₀: Las dos variables están distribuidas normalmente.

H₁: Al menos una de las variables no está distribuida normalmente.

Mediante software calculamos p-valor de la Prueba Shapiro-Wilk, y con α = 0.05 de significancia, obtenemos:

Para \(X: p-valor = 0.426 > 0.05\), no se rechaza H₀, entonces los datos de \(X\) provienen de una distribución normal.

Para \(Y: p-valor = 0.644 > 0.05\), no se rechaza H₀, entonces los datos de \(Y\) provienen de una distribución normal.

5. Estadístico de prueba:

\(t = \frac{r \sqrt{n - 2}}{\sqrt{1 - r^2}} = \frac{0.795 \sqrt{8 - 2}}{\sqrt{1 - 0.795^2}}= 3.21\)

6. Decisión:

Usamos un nivel de significancia \(α = 0.05\), con \(n−2 = 6\) grados de libertad; el valor crítico para una prueba bilateral es aproximadamente ±2.447.

Como \(∣t∣ > 2.447 → 3.21 > 2.447\) y \(p-value<0.05\), rechazamos H₀ y concluimos que hay una correlación significativa entre \(X\) e \(Y\).

Referencias: (1), (2), (3), (4), (5), (6), (7), (8), (9)

No hay comentarios:

Publicar un comentario